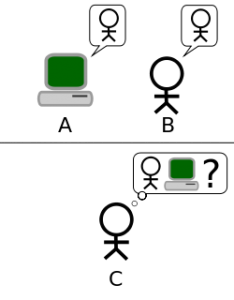

Mit dem Turing-Test kann eine Person durch das Stellen von Fragen herausfinden, ob ein Mensch oder eine Maschine antwortet. Für Socialbots gibt es noch keine eindeutige Methode, die Maschine zu entlarven. Bild: CC BY-SA 3.0 Hugo Férée

Können Maschinen Literatur schreiben? Schaut man sich die Vielzahl der literarischen Twitterbots an, lautet die Antwort: ja. Bots sind Accounts auf Twitter, hinter denen sich kein Mensch, sondern eine Software verbirgt, die automatisch twittert, retweetet oder anderen Usern folgt. Manche Twitterbots sind praktisch. Einige Zeitungen beispielsweise nutzen Twitterbots zum automatischen Retweeten von Nachrichten zu bestimmten Themen. Andere Twitterbots machen Literatur: Da gibt es den @JustToSayBot, der das Gedicht „This is just to Say“ von William Carlos Williams stündlich in Variationen mit zufälligen Wörtern twittert, oder den Bot, der Schneeballgedichte generiert, um nur zwei Beispiele zu nennen. Seit es Computer gibt, gibt es auch Versuche, literarische Texte von Algorithmen schreiben zu lassen. Vor allem mit dem Aufkommen der digitalen Literatur in den 1990er Jahren wurde diese Idee in Form von Lyrik-Generatoren in die Realität umgesetzt und hinterfragte damit das Verständnis von Autorschaft und Originalität.

Was bei den künstlerischen Twitterbots ein Spiel mit den neuen Medien ist, ist an anderer Stelle ein großes Problem. Sogenannte Socialbots werden von Politikern oder Organisationen genutzt, um die öffentliche Meinung in ihrem Sinne zu prägen. So haben laut FAZ sowohl Hillary Clinton als auch Donald Trump jeweils über eine Million Bots als treue Follower. Da viele Menschen mittlerweile Informationen hauptsächlich über soziale Netzwerke statt durch Nachrichten beziehen, ist diese Art der Propaganda besonders wirksam – und gefährlich. Wie einfach es ist, Hasskommentare durch Socialbots verbreiten zu lassen, zeigte der Versuch von Microsoft, einen Chatbot durch die Kommunikation auf sozialen Netzwerken lernen zu lassen. Die künstliche Intelligenz Tay hatte Accounts auf Twitter und anderen Plattformen. Je mehr die User mit ihr kommunizierten, desto mehr lernte sie. Nach wenigen Stunden schon gab der Chatbot nur noch rassistische und sexistische Tweets von sich, sodass Microsoft das Experiment abbrechen musste.

Auch wenn es streitbar bleibt, ob die Tweets der künstlerischen Bots wirklich als Literatur anzusehen sind, sind sie jedoch medienreflexiv und machen auf Probleme wie die Socialbots aufmerksam. Ein Twitterbot wie @KimKierkegaard, der Tweets von Kim Kardashian mit den philosophischen Äußerungen von Søren Kierkegaard zu neuen Tweets mischt („UGH I’m skipping workouts and eating bad!! But to despair over earthly things is a step towards despair of the eternal.”), ist vor allem lustig. Was auf den ersten Blick wie reiner Unsinn erscheint, reflektiert aber auch unseren Umgang mit den sozialen Medien und wirft Fragen auf: Wem wird auf welcher Grundlage Aufmerksamkeit zugesprochen? Was bedeuten Authentizität und Wahrhaftigkeit, wenn Inhalte von einer Software generiert werden können? Wie können wir zwischen realer Person und Roboter unterscheiden? Vor allem die letzte Frage beschäftigt die sozialen Netzwerke, denn der Anteil der falschen Accounts auf Twitter, Facebook und Co. lässt sich bisher nur schätzen. Der kritische Blick in die eigene Timeline lohnt sich also.

Von Ina Westermann